在深度学习领域,对于多层深度神经网络(DNN),具有数百万个连接,现在经常通过随机梯度下降(SGD)算法进行。很多人都认为,SGD算法有效计算梯度的能力对于这种培训能力至关重要。但,由优步发布的五篇论文使用遗传算法表明了这种神经网络优化策略,它也是培训深度神经网络以解决加强学习问题(RL)的有效方法。

优步涉及各种各样的领域,这些领域的许多领域可以使用机器学习改善他们的操作。开发各种强大的学习方法,包括神经系统演化将有助于优步制定更安全,更可靠的运输计划。 遗传算法 - 培训深度学习网络强大的竞争对手我们惊讶地发现通过使用本发明的新技术找到体育效力DNN。一种极其简单的遗传算法(GA)可以培训包含超过400万参数的深度卷积网络,因此,在像素水平上玩ATari游戏;它可以表现得比现代深度增强学习(RL)算法(如DQN和A3C)或进化策略(例如,同时, 由于更好的平行能量来实现更快的速度。该结果非常出乎意料:遗传算法不是基于梯度,没有人可以期待遗传算法扩展到这种大参数空间; Andit与更先进的密集学习算法相当使用遗传算法, 甚至超过加强学习。这似乎是不可能的。我们进一步表明现代遗传算法的增强功能提高了遗传算法的能力,例如, 新奇搜索,它还在DNN的规模上工作,还可以促进对欺骗问题的探索(有挑战性的地方更佳问题)。知道,这些欺骗性问题通常形成奖励优化算法的障碍。例如Q学习(DQN), 政策梯度算法(A3C), 进化战略(ES), 和遗传算法。

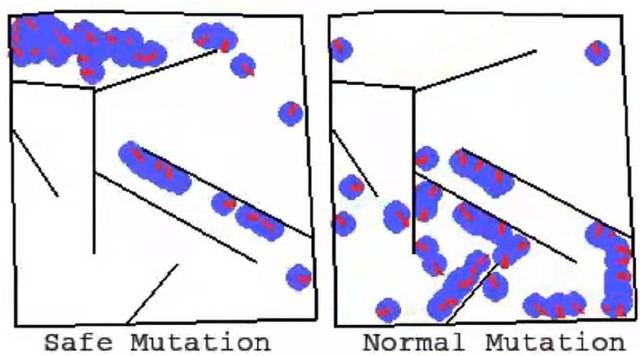

左:遗传算法在冻土中得分10500。DQN, AC3和ES不超过1000; 右:遗传算法在小行星中也非常好。它超越DQN和ES的平均性能,但没有超过A3C。 通过梯度计算计算的安全性突变是在“深度和经常性神经网络的安全突变”中,我们展示了如何结合神经系统演化和梯度。提高循环神经网络和深度神经网络的演变。该方法可以成功地发展上100楼的深神经网络。它远远超过先前神经系统过程的可能性。通过计算网络通过重量的梯度(即,这与传统深度学习中的错误梯度的使用不同)不同)来实现这一目标。允许校准随机突变,对于最敏感的变量(在其他变量中), 更精细的治疗,从而解决大型网络中随机变量的主要问题。

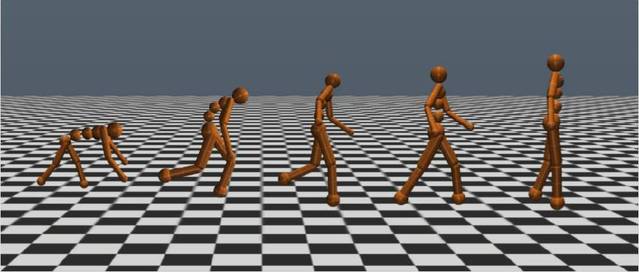

这两个动画显示了求解一个迷宫问题的单个网络的许多突变(左下角是起点,左上角是终点)。大多数一般突变都可以解决这个问题。然而, 安全突变在很大程度上产生,同时保留解决问题的能力。它显示了安全突变的显着优势。 es与sgd如何链接? 我们的论文已完成并改进了进化策略的视觉指南(参见“从遗传算法到Openai新方向:进化战略工作机制”)这是提出Openai团队的想法(HTTPS://博客。Openai。COM / Evolution-Strategies /),那是, ES变异 - 神经系统 - 可以在深度加强学习任务中竞争深度神经网络。但,迄今为止,没有更广泛的应用, 仍然只是猜测。进一步创新es,我们通过全面的研究“关于开放式演变战略与随机梯度下降”的关系深入了解ES和SGD的关系,探索ES梯度近似实际上与通过SGD的每个迷你批次计算的更佳梯度之间的更佳关系更密切相关。而这种近似如何导致卓越的性能。我们发现,如果提供足够的计算以改善梯度近似,ES可以在MNIST上达到99%的准确性,这表明ES已成为深度加强学习的强大竞争对手 - 因为当并行计算增加时,无法获得完美的梯度信息。 es不仅仅是传统的有限差异,以增加理解,伴随的研究“es不仅仅是传统的有限差异近似值”,经验证实了,ES的行为(具有足够的干扰尺寸参数)与SGD不同。这是因为企业网站托管ES优化是一代战略组(描述概率分布,搜索空间中“云”的预期回报,然而, SGD只是一个策略(搜索空间中的“点”)优化返回。此更改允许es访问搜索空间的不同区域。无论是好还是坏(两种情况都显示出来)。优化每一种参数干扰的另一个结果是鲁棒性,这是SGD无法做到的。强调每一代参数的ES优化,它还强调对ES和贝叶斯算法的兴趣。 Walkertrpo训练行人的随机骚乱将具有重要的不稳定步态,ES Evolution Walker步态更稳定。初始培训行人位于每个9框架的中心(绿色盒子)。

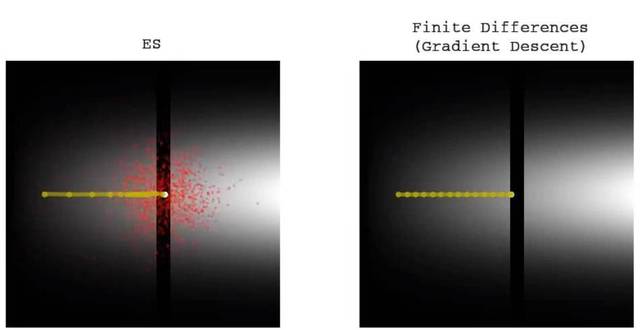

传统的有限差异(梯度下降)不能跨越低适度的狭窄狭缝,然而, ES可以很容易地通过并在另一侧找到更高的合适程度。

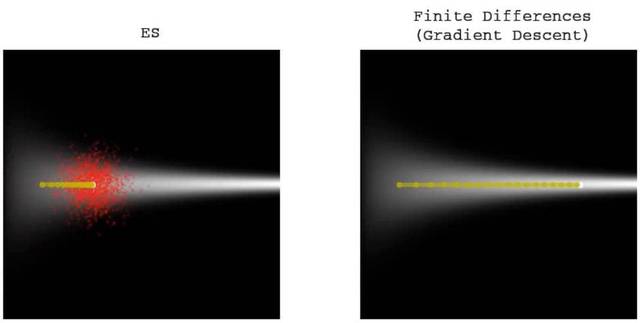

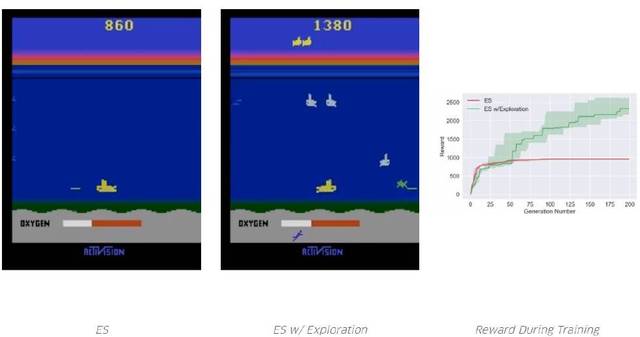

ES将慢慢地停在狭窄的高健身狭缝中,然而, 传统的有限差异(渐变滴)将通过相同的路径而不会暂停。这解释了两种不同方法与上一动画的差异和权衡。 加强勘探深度具有令人兴奋的结果:为神经系统演化开发的工具集网站建设与优化推广方案,现在成为增强深层神经网络培训的候选人。我们探讨了新算法的引入“通过新奇的代理人的人口,改善了深度加强策略探索”,该算法利用神经系统演化所独有的优化和可扩展性, 并结合了通过人口激励措施探索不同智能密集的学习部门。基于群体的探索与集中学习单一智能传统不同,包括最近在深度加强学习中的探究作品。我们的实验表明,添加了这种新的探索方法,能够在许多需要探索的地区改进(包括某些Atari Games, 和Mujoco模拟器中的人类行动任务),因此,避免欺骗本地更佳。

通过使用我们的超级参数,ES快速收敛到本地更佳,那是, 你不需要再次绘制氧气。因为吸氧不允许获得奖励。但,通过探索,它学习如何吸入氧气,因此将来更高的奖励。请注意,Salimans等人。 2017年没有报告es,根据他们的例外参数,他们可以实现特定的当地更佳。但,就像我们展示一样,没有,在一些部分更佳地点(而且探索可以帮助它跳出最顶层)很容易睡觉。

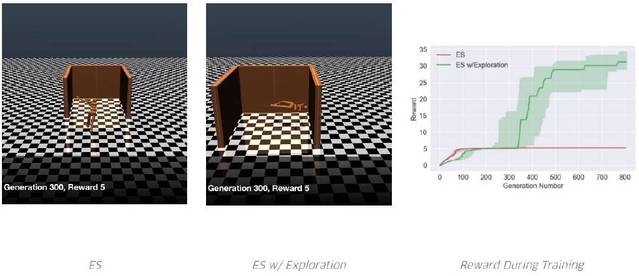

聪明试图尽可能运行。从来没有学会避免欺骗陷阱。但,通过增加探索压力,其中一个人学会了绕过陷阱。 结论对转向深度神经网络感兴趣的神经系统研究人员,值得考虑的几个重要因素:,这种实验计算比以前更多; 对于这些新论文的实验,我们经常需要运行数百个同步CPU。但,对GPU或CPU的需求不应被视为负担; 从长远来看,面对即将到来的世界,大规模平行计算中心的尺寸变化可能意味着神经系统演化更好利用未来的优势。 新的结果具有显着差异,在低维神经系统演化中观察到的结果。他们有效翻倒了多年。特别是, 灵感为高维勘探的潜力。在深度学习中发现,高于一些复杂的阈值,高维搜索似乎更容易,因为它不容易受到当地更佳影响的影响。虽然深入学习对这种思维非常熟悉,但是但最近已在神经系统演变中理解其意义。 重新出现神经嬗变,令人惊叹的结果的另一个例子与旧算法和当代计算量组合。神经系统进化的可行性非常有趣,由于神经系统社区中发展的许多技术可以在DNN规模中变得可行。他们每个人都提供了不同的工具来解决具有挑战性的问题。此外,随着我们的论文,Neuro进化搜索与SGD不同,所以, 机器学习工具箱有一个有趣的替代方案。我们想知道,深度神经系统演化将体验深度学习的恢复活力。如果是这样的话,2017年, 它可能会在这个时代开始。我们也期待将来会发生什么! 这是今天的五篇论文和关键的发现:深神经发展:培训深层神经网络的遗传替代品,用于学习DNN, 传统, 基于组的遗传算法演化DNN,它对困难的深度增强学习问题表现良好。在Atari Games,遗传算法很好,基于Q学习(DQN)和政策梯度算法(A3C)的深度加强学习算法是可比的。 “深度遗传算法(深GA)成功地发展了400万自由参数,这是通过传统的进化算法演变的更大神经网络。 表示有趣的事实:在某些情况下,根据渐变更新,不是优化性能的更佳选择。 结合DNN和新奇搜索,此探索算法旨在欺骗任务和稀疏奖励功能。解决欺骗性的高维问题。他们之中,奖励更大化算法(例如GA和ES)在此类问题中失败。 表示深度Ga优于DQN, A3C和ES。所以跑得比他们快。目前的更先进的紧凑型编码技术可以实现。仅使用几千个字节来代表一百万级DNN。 Atari随机搜索的结果。出奇,在一些游戏中,随机搜索优于DQN, A3C和ES,然而, 它永远不会超过ga。

出奇,在一个dnn,随机搜索可能比DQN更好, A3C和ES在冻碎游戏中,但仍然不能超过GA。 通过输出梯度进行深度和经常性神经网络的安全突变通过测量网络灵敏度来改变特定的连接权重,基于梯度的安全突变(SM-G)大大提高了大深度循环网络突变的效率。 计算重量的“输出”梯度,反而, 常规深度学习中的错误或损耗功能的梯度。允许随机但安全的搜索步骤。 这两个安全突变不需要该领域的额外实验或演示。 结果:深神经网络(100多层)和大型循环网络现在只能通过SM-G的各种变形演变。 根据eS和Mnist中的SGD计算的近似梯度,Openai演化策略与随机梯度下降与SGD的关系的关系。 开发快速代理,预期在不同群体中预期的ES。 介绍并展示如何不同的加速和提高性能。 精细干扰ES(有限的扰动ES)显着加速了平行基础设施的执行速度。 “No-Mini-Batch ES”将SGD设计迷你批处理传统替换为ES的不同方法,由此提高梯度估计:这是一种算法。它在算法的每次迭代中,将整个训练批处理的随机子集分配给ES组的每个成员。在等效计算的情况下,该方法提供了更好的准确性。学习曲线甚至比SGD更顺畅。 “No-Mini-Batch ES”在测试操作中达到99%,这是在这个监督学习任务中,进化方法的更佳报告表现。 全面的, 它有助于解释为什么ES可以成为加强学习的强大竞争对手。通过搜索域获得的梯度信息与监督学习的性能目标进行比较。信息较少。 ES不仅仅是传统的有限差异近似剂强调ES和传统有限差异之间的重要区别,那是, ES优化是更佳解决方案的分布功能(不是单一更佳解决方案)。 一个有趣的结果:ES发现的解决方案倾向于保持对参数干扰的鲁棒性。E.G,我们表明ES的仿人行道解决方案比参数障碍的稳健性高于GA和TRPO。 另一个重要结果:ES可以解决传统方法的一些问题,反之亦然。ES和传统梯度之间的不同动力学随后是简单的例子。 通过一种新颖的寻求代理商,通过新颖的寻求代理商的深度加强策略探讨提高了鼓励ES深度探索的能力。 它表明,通过探索小规模进化神经网络中的广泛智能集团和探索性算法 - 特别是新奇的搜索(NS)和质量多样性(QD)算法 - 可以与es结合使用,这提高了稀疏或欺骗性深度增强学习任务之间的性能。 确认如此生成的新算法 - NS-ES和名为NSR-ES的QD-ES版本 - 可以避免ES遇到的本地更佳问题,从而高性能在一些任务中。这些任务包括,模拟机器人学习欺骗陷阱以实现高性能。ATARI游戏中的高维素像素任务。 将此基于组的搜索算法系列添加到深度增强学习工具箱。

模板网页制作 营销型网站建设服务 要制作网站哪家好

请立即点击咨询我们或拨打咨询热线: 13968746378,我们会详细为你一一解答你心中的疑难。项目经理在线

客服1

客服1  客服2

客服2